Introduction

L’informatique moderne s’appuie de plus en plus sur des méthodes capables d’analyser de grandes quantités de données pour en tirer des prédictions ou des décisions. Parmi elles, l’algorithme des k plus proches voisins (souvent abrégé en k-NN, pour k-Nearest Neighbors) illustre une approche simple mais puissante : classer un nouvel élément en observant ceux qui lui ressemblent le plus dans un ensemble d’exemples connus. Ce principe, qui repose sur la proximité entre données, est utilisé aussi bien dans les systèmes de recommandation que dans la reconnaissance d’images ou l’analyse de textes. Son étude permet de relier l’algorithmique aux applications concrètes de l’intelligence artificielle.

Principe de l’algorithme des k plus proches voisins

L’idée de base de cet algorithme est intuitive : pour savoir à quelle catégorie appartient un nouvel élément, on regarde les k éléments les plus proches de lui et on choisit la catégorie majoritaire parmi eux.

Exemple : imaginons que tu veuilles classer une nouvelle chanson dans une playlist. Si les 5 chansons les plus proches d’elle (par tempo, instruments ou style) appartiennent à une playlist « rock », on placera logiquement la nouvelle chanson dans cette catégorie.

Le paramètre k désigne le nombre de voisins pris en compte. Un petit k peut rendre la classification sensible au hasard ou aux données bruitées, tandis qu’un k trop grand risque de diluer l’information et de donner une décision moins pertinente. Le choix de k dépend donc du problème étudié.

À retenir

L’algorithme des k plus proches voisins attribue une catégorie à un nouvel élément en fonction de ses k voisins les plus proches. La valeur de k influence directement la précision et la robustesse du résultat.

Mesure de la proximité entre données

Pour appliquer cet algorithme, il faut définir ce que signifie « être proche ». Cela dépend du type de données manipulées.

Pour des données numériques, la proximité est souvent mesurée par la distance euclidienne (la distance géométrique dans un espace de coordonnées).

Exemple : la distance entre (2, 3) et (5, 7) est √((5−2)² + (7−3)²) = 5.

D’autres distances simples existent, comme la distance de Manhattan, qui calcule la somme des différences absolues des coordonnées. Elle peut être comparée au trajet d’un taxi qui circule dans des rues en grille, d’où son nom.

Pour des textes, on peut utiliser le nombre de mots communs ou des méthodes plus avancées qui représentent les mots par des vecteurs numériques.

Pour des images, la proximité peut être calculée à partir de caractéristiques visuelles comme la couleur dominante ou la répartition des formes.

Le choix de la distance influence fortement la qualité de la classification. Deux objets peuvent sembler proches selon un critère et très éloignés selon un autre.

À retenir

La notion de proximité dépend du type de données et du critère choisi. La distance euclidienne est la plus courante, mais d’autres mesures simples comme la distance de Manhattan peuvent aussi être utilisées.

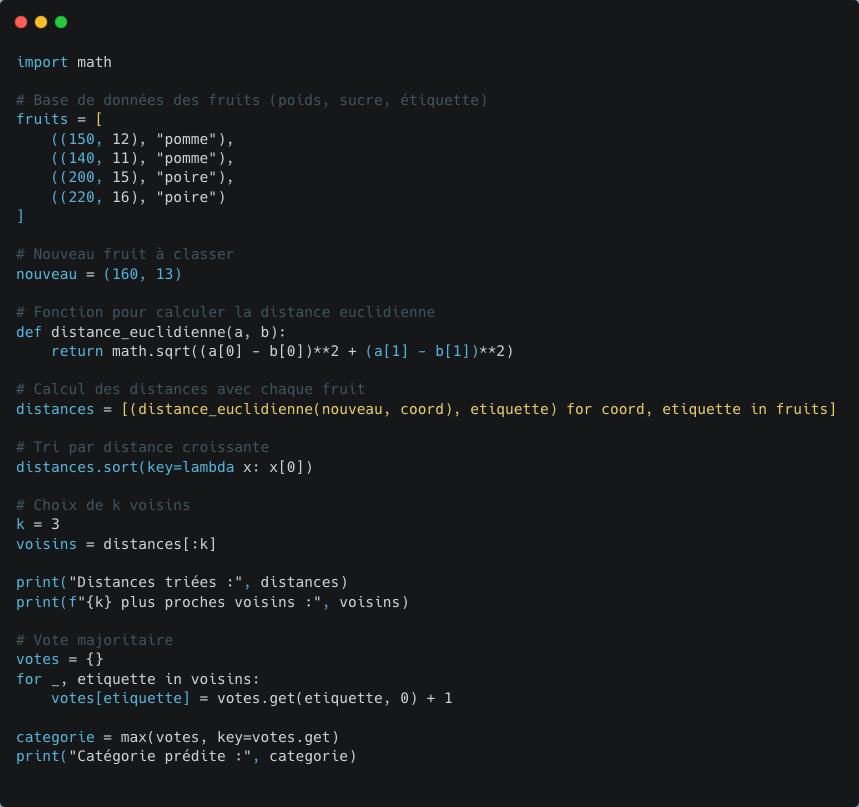

Exemple concret : classer un fruit

Imaginons que l’on dispose d’une base de données contenant des fruits caractérisés par leur poids (en grammes) et leur teneur en sucre (en g/100 g). Chaque fruit est déjà classé comme « pomme » ou « poire ».

Pomme A : (150 g, 12 g de sucre).

Pomme B : (140 g, 11 g de sucre).

Poire C : (200 g, 15 g de sucre).

Poire D : (220 g, 16 g de sucre).

On veut classer un nouveau fruit mesurant (160 g, 13 g de sucre).

En calculant les distances euclidiennes, on trouve que ses deux voisins les plus proches sont les pommes A et B. Si on choisit k = 3, les trois plus proches sont A, B et C. La majorité est donc « pomme » : le fruit sera classé comme une pomme.

Cet exemple montre comment l’algorithme prend une décision par comparaison, sans modèle complexe ni calcul préalable.

À retenir

L’algorithme des k plus proches voisins repose sur un principe simple de vote majoritaire, mais il est capable de classer efficacement de nouvelles données à partir d’exemples connus.

Avantages et limites de l’algorithme k-NN

L’un des grands atouts de l’algorithme k-NN est sa simplicité : il ne nécessite pas d’entraînement préalable ni de calcul compliqué. Il s’appuie uniquement sur les données existantes et peut s’adapter à différents types de situations. Il est donc utilisé comme méthode de référence pour comparer d’autres techniques plus sophistiquées.

Cependant, il présente plusieurs limites :

Son efficacité dépend directement de la qualité et du volume des données disponibles.

Il peut être très coûteux en calcul quand la base est grande, car il faut mesurer la distance avec chaque élément.

La présence de données mal étiquetées ou atypiques peut fausser les résultats.

Le choix de k et de la mesure de distance est crucial pour obtenir des résultats pertinents.

Dans le cadre du programme de Première, le k-NN est limité à la classification : il n’est pas utilisé pour prédire des valeurs numériques (ce qu’on appelle « régression »), afin d’éviter toute confusion avec d’autres usages possibles de cet algorithme.

À retenir

Le k-NN est simple, intuitif et adaptable, mais il devient lent et imprécis avec des bases de données massives ou bruitées. Dans ce niveau, il est uniquement utilisé pour des problèmes de classification.

Conclusion

Classer par proximité, comme le fait l’algorithme des k plus proches voisins, illustre une idée clé de l’informatique : utiliser la ressemblance entre données pour anticiper et décider. C’est une première approche de l’intelligence artificielle, accessible mais riche d’enseignements. Elle montre comment une règle locale et simple peut résoudre un problème de classification, tout en révélant les enjeux liés au volume de données et au choix des paramètres. Dans la suite du programme, d’autres méthodes d’apprentissage automatique permettront d’aller au-delà de cette logique de comparaison directe et d’optimiser les classifications de manière plus robuste.